Проверка поставщика услуг ремонта — официальная служба поддержки Apple

Проверьте, есть ли у вашего поставщика доступ к оригинальным запасным частям и ресурсам по ремонту Apple.

Подождите, выполняется загрузка страницы проверки поставщика услуг ремонта

страница проверки поставщика услуг ремонта загружена

Подождите, выполняется загрузка городов

Загруженных городов:

Подождите, выполняется загрузка списка поставщиков

Загруженных поставщиков:

Подождите, выполняется обновление списка поставщиков

список поставщиков обновлен; добавлено результатов:

Раскрывающийся список стран отфильтрован; доступных стран: .

Раскрывающийся список городов отфильтрован; доступных городов: .

Найдено результатов:

Авторизованный сервисный центр компании Apple Независимый поставщик услуг ремонта Планирование обслуживания в Apple Посещение веб-сайта

Авторизованный сервисный центр компании Apple

В авторизованных сервисных центрах компании Apple предоставляются услуги сертифицированного гарантийного и негарантийного ремонта продуктов Apple. Технические специалисты авторизованных сервисных центров компании Apple проходят обучение и используют в работе только оригинальные запасные части, инструменты, средства диагностики и ресурсы. Для таких ремонтов компания Apple предоставляет поддержку.

Независимый поставщик услуг ремонта

Независимые поставщики услуг ремонта — это компании, которые предоставляют негарантийный ремонт устройств iPhone и компьютеров Mac. У этих компаний есть доступ к оригинальным запасным частям, инструментам, учебным материалам, диагностике и ресурсам Apple для выполнения различных негарантийных ремонтов устройств iPhone и компьютеров Mac, таких как замена дисплея и аккумулятора iPhone, а также замена материнской платы и видеокарты Mac.

Программа независимых поставщиков услуг ремонта

Выберите страну или регионAustraliaBelgiëBelgiqueBrasilБългарияCanada (English)Canada (Français)ČeskoDanmarkDeutschlandEestiEspañaΕλλάδαFranceHong Kong (English)香港HrvatskaIcelandIndiaIndonesiaIrelandItalia日本대한민국ΚύπροςLatvijaLiechtensteinLietuvaLuxembourg (Français)澳門MagyarországMalaysiaMaltaMéxicoNederlandNew ZealandNorgeÖsterreichPhilippinesРоссияPolskaPortugalRomâniaSaudi Arabia (English)المملكة العربية السعوديةSchweizSuisse (Français)SingaporeSlovenijaSlovenskoSuomiSverige台灣ไทยTürkiyeUnited Arab Emirates (English)الإمارات العربية المتحدةUnited KingdomUnited StatesVietnamOther AfricaOther AsiaOther Europe Страна/регион При изменении этого элемента управления страница автоматически обновится

Программа независимых поставщиков услуг ремонта предназначена для компаний, заинтересованных в оказании услуг негарантийного ремонта устройств iPhone и компьютеров Mac.![]()

Кто может подать заявку?

Заявку могут подавать компании, заинтересованные в выполнении негарантийных ремонтов устройств iPhone или компьютеров Mac непосредственно для конечных пользователей. Apple не будет рассматривать заявителей, использующих товарные знаки Apple в названиях компаний или на веб-страницах, за исключением случаев, когда такое использование соответствует Условиям использования товарных знаков Apple.

Дилеры и дистрибьюторы запасных частей не могут принимать участие в этой программе. Авторизованные дилеры компании Apple не могут принимать участие в этой программе, но вправе подать заявку на участие в программе Авторизованный сервисный центр компании Apple.

Каковы требования?

Требования к организации и рабочему процессу

У компаний, подающих заявки, должны быть налажены деловые процессы, а также должны быть документы, подтверждающие деятельность, которые доступны для проверки компанией Apple. Компания должна обеспечивать конфиденциальность сведений об инструментах для ремонта, учебных материалов, руководств по обслуживанию и средств диагностики Apple.

Помещение

Для соответствия требованиям у компании должен быть коммерческий сервисный центр для приема клиентов, расположенный в удобном месте. Домашний адрес не может быть адресом сервисного центра.

Сертификация технических специалистов

В участвующих в программе сервисных центрах, где используются оригинальные запасные части Apple, ремонт должны выполнять технические специалисты, сертифицированные Apple.

Чтобы получить сертификат на ремонт продуктов Apple, необходимо сдать онлайн-экзамены в авторизованном центре тестирования.

Подробную информацию о подготовительных курсах и экзаменах для сертификаций Apple можно найти здесь.

Порядок подачи заявки

В настоящее время мы принимаем заявки от компаний в России. Отправьте сообщение электронной почты с заполненной формой уведомления о заинтересованности в получении статуса независимого поставщика услуг ремонта по адресу

Что такое Service Provider Foundation?

- 000Z» data-article-date-source=»ms.date»>04/15/2020

- Чтение занимает 6 мин

В этой статье

Важно!

Эта версия Service Provider Foundation (SPF) достигла конца поддержки, мы рекомендуем выполнить обновление до SPF 2019.

System Center — диспетчер виртуальных машин (VMM) предоставляет все ресурсы, необходимые для создания, обслуживания и мониторинга облачной инфраструктуры. Однако поставщики услуг и крупные предприятия требуют дополнительных функций для поддержки нескольких клиентов, интеграции инфраструктур с сложными веб-порталами самообслуживания и распределения рабочих нагрузок управления в нескольких центрах обработки данных.

System Center-Service Provider Foundation (SPF), объединенный с System Center Orchestrator, предоставляет эту возможность с помощью расширяемого API Open Data Protocol через веб-службу передачи данных о состоянии (RESTful), которая взаимодействует с VMM.

SPF может использоваться поставщиками услуг для предоставления клиентам инфраструктуры как услуги (IaaS). Если поставщик услуг имеет интерфейсный портал для клиентов, клиент может выполнять запросы к ресурсам поставщика услуг размещения, не открывая портал. Облачные ресурсы, предоставляемые VMM, можно управлять с помощью стандартных интерфейсов управления с поддерживаемых устройств где угодно.

На следующем рисунке показано, как работает SPF.

Службы SPF

SPF предоставляет ряд служб:

- Веб-служба администрирования: предоставляет серверы, клиенты и отметки для Service Provider Foundation.

- Служба VMM: предоставляет доступ к возможностям VMM

- Служба поставщика: используется Windows Azure Pack

Веб-служба администрирования

- Поставщики услуг размещения используют веб-службу администрирования для создания клиентов, ролей пользователей, серверов, штампов и других административных объектов и управления ими.

- Доступ к веб-службе администрирования можно получить с помощью URL-адреса https://server:8090/SC2012R2/Admin/Microsoft.Management.Odata.svc

Примечание

Приведенный выше URL-адрес применим для SPF 2016 и более поздних версий.

- Требуются следующие учетные данные.

| Учетные данные | Требование |

|---|---|

| Удостоверение пула приложений администрирования в IIS | Должен быть членом группы администраторов и группы SPF_Admin. |

| Группа администраторов в оснастке «Управление компьютером» | Должны быть включены учетные данные для удостоверения пула приложений администрирования |

| Группа SPF_Admin в разделе «Управление компьютером» | Необходимо включить локального пользователя, который является членом группы администраторов, и учетные данные для удостоверения пула приложений администратора. |

Веб-служба VMM

Веб-служба VMM вызывает VMM для выполнения запрошенных операций, таких как создание виртуальных машин, виртуальных сетей, определений ролей пользователей и другой структуры для облака. Эта служба координирует изменения между участниками и обеспечивает следующие динамические возможности.

Эта служба координирует изменения между участниками и обеспечивает следующие динамические возможности.

- Приложения портала и другие клиенты обнаруживают изменения, внесенные в SPF и VMM.

- В VMM отображаются изменения, внесенные приложениями портала, другими клиентами и Service Provider Foundation.

- Service Provider Foundation отражает все изменения, внесенные участниками.

Для регистрации экземпляра VMM можно использовать командлет PowerShell T:Microsoft.SysТемцентер. Foundation. командлет. New-SCSPFServer. Доступ к веб-службе VMM можно получить с помощью URL-адреса https://server:8090/SC2012R2/VMM/Microsoft.Management.Odata.svc

Примечание

Приведенный выше URL-адрес применим для SPF 2016 и более поздних версий.

| Учетные данные | Требование |

|---|---|

| Удостоверение пула приложений VMM в IIS | Должен быть членом группы администраторов и группы SPF_VMM. |

| Группа администраторов в оснастке «Управление компьютером» | Должны быть включены учетные данные для удостоверения пула приложений VMM |

| Группа SPF_VMM в разделе «Управление компьютером» | Необходимо включить локального пользователя, который является членом группы администраторов, и учетные данные для удостоверения пула приложений VMM. |

| Роль пользователя «Администратор» в VMM | Необходимо включить учетные данные для удостоверения пула приложений VMM в качестве члена роли пользователя «Администратор». |

Веб-служба использования

- Веб-служба использования используется только Windows Azure Pack и сторонними поставщиками выставления счетов. Конечная точка веб-службы использования не должна быть доступна для других целей, чтобы предотвратить потери данных из-за ненужных или ошибочных запросов.

- Веб-служба использования использует регистрации экземпляров Operations Manager хранилищ данных (которые размещаются в VMM) для сбора метрик использования виртуальной машины клиента и другого использования структуры.

Данные об использовании собираются для таких процессов, как возвратный платеж.

Данные об использовании собираются для таких процессов, как возвратный платеж. - Командлеты Windows PowerShell можно использовать для регистрации Operations Manager параметров подключения к хранилищу данных в базе данных SPF. Эта регистрация позволяет SPF собирать данные об использовании из хранилищ данных.

- Веб-служба использования возвращает данные об использовании, относящиеся ко всем подпискам служб.

| Учетные данные | Требование |

|---|---|

| Удостоверение пула приложений использования в IIS | Должен быть членом группы администраторов и _ группы использования SPF. |

| Группа администраторов в оснастке «Управление компьютером» | Должны быть включены учетные данные для удостоверения пула приложений использования. |

| Группа «использование SPF» в оснастке » _ Управление компьютером» | Необходимо включить локального пользователя, который является членом группы администраторов, и учетные данные для удостоверения пула приложений использования. |

| Пользователь dbo базы данных в базе данных OperationsManagerDW SQL Server (на сервере Operations Manager) | Учетные данные пользователя, установившего Operations Manager, автоматически используются для входа в объект безопасности dbo SQL Server. Одни и те же учетные данные должны использоваться для всех удостоверений пула приложений SPF. |

Свойства базы данных SQL Server OperationsManagerDW (щелкните правой кнопкой мыши) на сервере Operations Manager.

Веб-служба поставщика

Поставщики ресурсов для предоставления инфраструктуры как услуги (IaaS) используют веб-службу поставщика. Веб-служба поставщика предоставляет веб-интерфейс API Microsoft ASP.NET. Он не является службой Open Data (OData). Веб-служба поставщика также использует веб-службы VMM и администрирования.

| Учетные данные | Требование |

|---|---|

| Удостоверение пула приложений поставщика в IIS | Должен быть членом групп администраторов, SPF_Provider, SPF_VMM и SPF_Admin групп. |

| Группа администраторов в оснастке «Управление компьютером» | Должны быть включены учетные данные для удостоверения пула приложений поставщика |

| Группа SPF_Provider в разделе «Управление компьютером» | Необходимо включить локального пользователя, который является членом группы администраторов, и учетные данные для удостоверения пула приложений поставщика. |

Веб-служба Service Management Automation.

События можно настроить в SPF, что будет использоваться веб-службой Service Management Automation. Для этого веб-служба должна иметь учетные данные для доступа к веб-службам SPF. Кроме того, можно использовать PowerShell для автоматизации модулей Runbook.

| Учетные данные | Требование |

|---|---|

| Одно или несколько удостоверений пула приложений SPF, необходимых для автоматизации | Должен быть членом группы администраторов на сервере с установленными Service Management Automation. |

Взаимодействие с SPF

Поставщик услуг размещения и клиенты взаимодействуют с SPF следующим образом:

- Поставщики услуг размещения используют службу администрирования для выделения пропускной способности сети, места на диске и серверов, которые вместе представляют частное облако для клиентов.

- Клиенты представляют клиента с ресурсом-контейнером в системе поставщика услуг размещения. Клиенты используют и управляют службами, предлагаемыми поставщиком услуг размещения. С каждым клиентом связаны собственные администраторы, приложения, скрипты и другие средства.

- Поставщик услуг размещения управляет ресурсами, доступными для каждого клиента. Поставщик услуг размещения имеет существующий интерфейсный портал, который могут использовать все клиенты.

- Службы клиента подготавливаются для пользователей самообслуживания администраторами клиентов в виде сетей виртуальных машин, виртуальных машин, виртуального оборудования и облачной инфраструктуры.

- Поставщик услуг размещения выделяет ресурсы структуры в штампе. Ресурсы клиента могут быть распределены по отметкам любым способом, подходящим для поставщика услуг размещения. Ресурсы можно разделить на несколько отметок (определенный набор ресурсов).

- SPF позволяет поставщику услуг размещения обеспечить в клиенте удобный пользовательский интерфейс путем агрегирования данных из каждой отметки и предоставления клиенту возможности использовать API-интерфейсы SPF для доступа к этим данным.

- По мере увеличения спроса на клиенты поставщик услуг размещения предоставляет дополнительные штампы для удовлетворения этого спроса.

- Каждый экземпляр VMM, взаимодействующий с SPF, называется меткой управления. SPF может работать с максимум пятью штампами.

- Метка — это экземпляр System Center, который поддерживает виртуализованную инфраструктуру платформы, состоящую из сервера VMM, узлов, виртуальных машин и параметров конфигурации, таких как учетные записи служб и роли пользователей.

Метки обеспечивают логическую границу. Например, можно иметь отдельную отметку для каждого сайта, управляемого сервером VMM.

Метки обеспечивают логическую границу. Например, можно иметь отдельную отметку для каждого сайта, управляемого сервером VMM. - Отметки должны быть способны отслеживаться и включать экземпляр System Center Operations Manager. Экземпляр Operations Manager может обеспечить мониторинг нескольких отметок.

- Метка — это экземпляр System Center, который поддерживает виртуализованную инфраструктуру платформы, состоящую из сервера VMM, узлов, виртуальных машин и параметров конфигурации, таких как учетные записи служб и роли пользователей.

- Администраторы клиентов могут взаимодействовать с структурой VMM, настраивая облака, шаблоны, роли пользователей и пользователей самообслуживания. У администратора клиента также есть возможности самообслуживания пользователей.

- Пользователи самообслуживания предоставляются с подмножеством ресурсов клиента для работы с. Использование ресурсов регулируется квотой. Например, когда пользователи развертывают виртуальные машины или используют другие ресурсы, они получают точки с квотами до количества выделенных точек квот. Пользователи самообслуживания могут взаимодействовать со службами, шаблонами и виртуальными жесткими дисками для развертывания виртуальных машин и управления ими.

На этом рисунке показано, как SPF взаимодействует с VMM

VMM, SPF и Windows Azure Pack

Windows Azure Pack предоставляет возможности Azure и интерфейсного интерфейса для облаков Организации. Пакет Azure предоставляет ряд компонентов, а также облачную службу виртуальных машин. Облачная служба виртуальных машин интегрируется с VMM для предоставления следующих услуг:

Портал управления для администратора, позволяющий включить размещение или службу, предоставляет возможность настройки инфраструктуры подготовки виртуальных машин.

Портал клиента, на котором клиенты могут зарегистрироваться для использования службы облаков виртуальных машин, и подготавливать виртуальные машины. Windows Azure Pack использует SPF для интеграции с VMM для предоставления службы облаков виртуальных машин, как показано на следующем рисунке.

Следующие шаги

Планирование развертывания SPF

EDS | EBSCO Discovery Service

Самый мощный единый поиск

Объединяя контент и технологии, EBSCO Discovery Service (EDS) обеспечивает доступ ко всей вашей библиотеке через наиболее релевантные и точные результаты поиска.

EDS предоставляет мощные средства поиска в богатой и разнообразной коллекции информационных ресурсов Вашей организации. EDS поддерживает поиск контента в полнотекстовых, реферативных базах данных, а также библиотечных каталогах и других локальных коллекциях. Интегрированный поиск осуществляется за счет сбора и индексирования метаданных из различных источников в единый предварительно проиндексированный массив, что обеспечивает максимально быстрый ответ на поисковый запрос пользователя.

EDS также предлагает:

- Самые качественные метаданные

- Наилучшую релевантность

- Наиболее полная коллекция проиндексированного контента, в том числе реферативные и библиографические базы данных, полнотекстовые коллекции и ресурсы открытого доступа от примерно 23,800-провайдеров, на которые приходится более 1 000 000 изданий от ведущих мировых издательств и поставщиков информации.

- Полная интеграция базы знаний и функции управления

- Расширение через API

- Возможность использовать контролируемые словари для ключевых предметных указателей

- Интуитивно понятный, многоуровневый интерфейс поиска с функцией базового и расширенного поиска

- Возможность отображения информации о доступности публикации, ее местоположении, ссылки на полный текст, настройка примечаний

- Возможность использования папок для сохранения и управления рузультатами поиска

- Ограничители и расширители, созданные для сужения результатов поиска, ориентирующие пользователя на лучшие результаты, основанные на формате, месте нахождения, доступности внутри библиотеки, а также в соответствии с другими критериями.

- Опции вывода на печать, отправки по электронной почте, сохранения, экспортирования и форматирования библиографических ссылок

- Сервис закладок в социальных сетях

- Обогащение данных для каталожных записей, включая отображение сторонних материалов через установку приложений

- Круглосуточный доступ к службе поддержки на платформе, а также служба онлайн поддержки, обучение для администраторов и конечных пользователей

Локальный контент

Одной из составных частей EBSCO Discovery Service (единого поискового окна) является загрузка электронного каталога библиотеки и институционального репозитория, благодаря данной функции, в рамках единого поиска могут быть отображены результаты из различных ресурсов.

Благодаря EDS библиотеки могут перенять опыт EBSCO в области загрузки и обогащения данных, чтобы предложить своим пользователям наиболее удобный поиск через web-интерфейс.

Используйте EDS в других интерфейсах через API

EBSCO Discovery Service API (интерфейс прикладного программирования) обеспечивает функциональность поиска в АБИС библиотеки (автоматизированной библиотечной информационной системе).

С EBSCO Discovery Service API библиотеки имеют доступ к премиум-контенту, предоставляемому по подписке EDS через пользовательский интерфейс по выбору библиотеки. Программный интерфейс приложения (API) разработан с учетом простоты, предлагая легкую интеграцию и прямолинейную технологию, что позволяет библиотекам реализовать уникальный опыт применения пользовательского интерфейса.

Наряду с доступом к массиву метаданных из центрального индекса, API EDS предлагает множество наиболее важных функций и функциональных возможностей EDS, в том числе высокую степень релевантности, прямую привязку к полному тексту, полный список ограничителей и расширений для поиска и поддержку гостевых и удаленных пользователей.

АБИС-партнерство означает более широкий выбор для библиотек

Благодаря партнерству с крупнейшими поставщиками и разработчиками АБИС, EBSCO предоставляет библиотекам выбор при обслуживании конечных пользователей. Библиотеки могут использовать преимущества обоих сервисов, т.е. использовать в качестве пользовательского интерфейса EBSCO Discovery Service или интерфейс электронного каталога библиотеки. Благодаря этому, совместные клиенты получают возможность улучшенного доступа к базам данных, журналам, материалам конференций, газетам, электронным книгам, изображениям, видеоматериалам и другим ресурсам, предоставляемым библиотеками.

Партнерство EBSCO с разработчиками АБИС выражает свою приверженность к интеграции со сторонними сервисами. С этой целью, в настоящее время EBSCO работает с более чем шестьюдесятью поставщиками, и их число постоянно растет. Компания EBSCO с радостью рассмотрит ваши предложения относительно будущего сотрудничества.

Благодаря партнерству EBSCO с разработчиками АБИС подписчики EDS получают:

- Экономию времени при инсталляции и обслуживании. Партнерство с разработчиками АБИС позволяет расширить интеграцию рабочего процесса посредством использования EDS API в каталоге библиотеки.

- Большую доступность ценных ресурсов посредством единого поиска.

- Удобство в работе с интерфейсом благодаря наличию таких функций АБИС, как: проверка возврата изданий, резервирование, продление, доступ к истории в личном кабинете и просмотр задолженностей.

- Повысить ценность и используемость ресурсов Вашей библиотеки с EBSCO Discovery Service.

Secret Service — Авторизованный Сервисный Центр

12 mini12 Pro Max12 Pro12SE 202011 Pro Max11 Pro11XS MaxXSXRX8 Plus87 PlusSE 1-gen76S Plus6S6 Plus6

Гарантийное обслуживаниеГарантийное обслуживаниеГарантийное обслуживаниеГарантийное обслуживаниеГарантийное обслуживаниеГарантийное обслуживаниеГарантийное обслуживаниеГарантийное обслуживаниеГарантийное обслуживаниеГарантийное обслуживаниеАктивацияАктивацияГарантийное обслуживаниеАктивацияГарантийное обслуживаниеАктивацияГарантийное обслуживаниеГарантийное обслуживаниеАктивацияГарантийное обслуживаниеГарантийное обслуживаниеГарантийное обслуживаниеГарантийное обслуживаниеГарантийное обслуживаниеАктивацияАктивацияГарантийное обслуживаниеАктивацияАктивацияЗамена дисплеяЗамена дисплеяГарантийное обслуживаниеЗамена дисплеяАктивацияЗамена дисплеяАктивацияАктивацияАктивацияЗамена дисплеяАктивацияЗамена дисплеяАктивацияАктивацияВариант замены на iPhone серии 12 Замена устройстваЗамена дисплеяАктивацияЗамена дисплеяЗамена устройстваЗамена устройстваЗамена устройстваЗамена дисплеяЗамена устройстваЗамена дисплеяЗамена устройстваЗамена дисплеяЗамена устройстваЗамена устройстваЗамена дисплея (от)Замена дисплеяЗамена нижней части устройстваЗамена дисплеяЗамена устройстваЗамена устройстваЗамена дисплеяЗамена устройстваЗамена дисплеяЗамена аккумулятораЗамена аккумулятораЗамена аккумулятораЗамена устройстваЗамена аккумулятораЗамена устройстваЗамена устройстваЗамена аккумулятораЗамена устройстваЗамена аккумулятораЗамена аккумулятораЗамена устройства (от)Замена устройстваЗамена нижней части устройстваЗамена устройстваЗамена аккумулятораЗамена устройстваЗамена аккумулятораЗамена устройстваЗамена аккумулятораЧистка сеток динамиков, разъёмовЗамена аккумулятораЧистка сеток динамиков, разъёмовЧистка сеток динамиков, разъёмовЧистка сеток динамиков, разъёмовЗамена аккумулятораЧистка сеток динамиков, разъёмовЗамена аккумулятораЧистка сеток динамиков, разъёмовЗамена аккумулятораЧистка сеток динамиков, разъёмовЗамена дисплеяЧистка сеток динамиков, разъёмовЗамена аккумулятораЗамена нижней части устройстваЗамена аккумулятораЗамена дисплеяЗамена аккумулятораЧистка сеток динамиков, разъёмовДиагностикаЧистка сеток динамиков, разъёмовЧистка сеток динамиков, разъёмовДиагностикаДиагностикаЗамена дисплеяДиагностикаДиагностикаЧистка сеток динамиков, разъёмовДиагностикаЗамена устройстваЧистка сеток динамиков, разъёмовДиагностикаЧистка сеток динамиков, разъёмовЧистка сеток динамиков, разъёмовЧистка сеток динамиков, разъёмовДиагностикаЧистка сеток динамиков, разъёмовДиагностикаКонсультацияДиагностикаКонсультацияКонсультацияКонсультацияКонсультацияДиагностикаДиагностикаКонсультацияДиагностикаДиагностикаКонсультацияДиагностикаКонсультацияДиагностикаЗамена аккумулятораДиагностикаЗамена нижней части устройстваКонсультацияПроверка права обслуживанияУслуга сохранения данныхКонсультацияУслуга сохранения данныхКонсультацияУслуга сохранения данныхУслуга сохранения данныхЗамена аккумулятораУслуга сохранения данныхПроверка права обслуживанияУслуга сохранения данныхЗамена аккумулятораПроверка права обслуживанияУслуга сохранения данныхКонсультацияУслуга сохранения данныхУслуга сохранения данныхКонсультацияЧистка сеток динамиков, разъёмовКонсультацияЗамена аккумулятораЧистка сеток динамиков, разъёмовУслуга сохранения данныхПредпродажная подготовкаПредпродажная подготовкаПредпродажная подготовкаУслуга сохранения данныхПредпродажная подготовкаПредпродажная подготовкаЧистка сеток динамиков, разъёмовЗамена дисплеяПредпродажная подготовкаУслуга сохранения данныхПредпродажная подготовкаУслуга сохранения данныхПредпродажная подготовкаУслуга сохранения данныхПредпродажная подготовкаПредпродажная подготовкаУслуга сохранения данныхУслуга сохранения данныхПредпродажная подготовкаПредпродажная подготовкаУслуга сохранения данныхПредпродажная подготовкаДиагностикаДиагностикаДиагностикаПредпродажная подготовкаЧистка сеток динамиков, разъёмовПредпродажная подготовкаПредпродажная подготовкаПредпродажная подготовкаПроверка права обслуживанияПроверка права обслуживанияДиагностикаПроверка права обслуживанияУслуга сохранения данныхУслуга сохранения данныхУслуга сохранения данныхПроверка права обслуживанияПредпродажная подготовкаПредпродажная подготовкаПредпродажная подготовкаУслуга сохранения данныхАктивацияАктивацияПредпродажная подготовкаАктивация

2017/2018/ 2019/2020Pro 12..jpg) 9 2018/2020Pro 12.9 2016/2017Pro 11Pro 10.5Pro 9.7mini 5mini 4mini 3mini 2miniAir 2Air65

9 2018/2020Pro 12.9 2016/2017Pro 11Pro 10.5Pro 9.7mini 5mini 4mini 3mini 2miniAir 2Air65

Гарантийное обслуживаниеГарантийное обслуживаниеГарантийное обслуживаниеГарантийное обслуживаниеГарантийное обслуживаниеАктивацияГарантийное обслуживаниеАктивацияГарантийное обслуживаниеГарантийное обслуживаниеАктивацияГарантийное обслуживаниеГарантийное обслуживаниеГарантийное обслуживаниеГарантийное обслуживаниеАктивацияГарантийное обслуживаниеАктивацияАктивацияАктивацияАктивацияЗамена устройстваАктивацияЗамена устройстваЗамена устройстваЗамена устройстваАктивацияАктивацияЗамена устройстваАктивацияАктивацияЗамена устройстваДиагностикаЗамена устройства отЗамена устройстваДиагностикаЗамена устройстваЗамена устройстваДиагностикаЗамена устройстваДиагностикаЗамена устройстваДиагностикаЗамена устройстваДиагностикаКонсультацияДиагностикаДиагностикаДиагностикаКонсультацияДиагностикаДиагностикаКонсультацияДиагностикаКонсультацияДиагностикаКонсультацияКонсультацияУслуга сохранения данныхКонсультацияУслуга сохранения данныхКонсультацияКонсультацияУслуга сохранения данныхАктивацияАктивацияКонсультацияКонсультацияУслуга сохранения данныхКонсультацияУслуга сохранения данныхУслуга сохранения данныхПредпродажная подготовка, проверка устройстваУслуга сохранения данныхПредпродажная подготовка, проверка устройстваУслуга сохранения данныхУслуга сохранения данныхПредпродажная подготовка, проверка устройстваУслуга сохранения данныхУслуга сохранения данныхПредпродажная подготовка, проверка устройстваУслуга сохранения данныхГарантийное обслуживаниеПредпродажная подготовка, проверка устройстваГарантийное обслуживаниеПредпродажная подготовка, проверка устройстваПредпродажная подготовка, проверка устройстваКонсультацияЗамена устройства (от)Предпродажная подготовка, проверка устройстваПредпродажная подготовка, проверка устройстваЗамена устройстваПредпродажная подготовка, проверка устройстваПредпродажная подготовка, проверка устройстваПредпродажная подготовка, проверка устройстваУслуга сохранения данныхДиагностикаДиагностикаПредпродажная подготовка, проверка устройстваКонсультацияКонсультацияУслуга сохранения данныхУслуга сохранения данныхПредпродажная подготовка, проверка устройстваПредпродажная подготовка, проверка устройства

ProAir12

Гарантийное обслуживаниеГарантийное обслуживаниеГарантийное обслуживаниеДиагностикаДиагностикаДиагностикаЧистка системы охлажденияЧистка системы охлажденияЧистка системы охлажденияЗамена устройстваЗамена устройстваЗамена устройстваЗамена дисплея (от)Замена дисплея 13″ (от)Замена АКБ (от года выпука)Замена SSD до 2018 (от)Замена дисплея 15″ (от)Замена Top Case (от года выпуска)Замена Top Case (от)Замена Top Case по АКБ (от)Замена системной платы (от года выпуска)Замена Top Case по АКБ (от года выпуска)Обновление OSСохранение данных (от)Сохранение данные (от)Предпродажная подготовка, проверка устройства (от)Предпродажная подготовка, проверка устройстваРазблокировка EFI пароляРазблокировка EFI пароляОбновление OSЗамена АКБ (от года выпука)Обновление OS

Mac miniMac ProiMac

Гарантийное обслуживаниеГарантийное обслуживаниеГарантийное обслуживаниеДиагностикаДиагностикаДиагностикаЗамена устройстваЧистка системы охлаждения после 2012 (тонкий корпус)Замена устройстваРазблокировка EFI пароляЧистка системы охлаждения до 2012 (с DVD)Разблокировка EFI пароляСохранение данные (от)Замена устройстваСохранение данные (от)Предпродажная подготовка, проверка устройстваСохранение данные (от)Предпродажная подготовка, проверка устройстваРазблокировка EFI пароляПредпродажная подготовка, проверка устройства

4KHD

Гарантийное обслуживаниеГарантийное обслуживаниеАктивацияАктивацияЗамена устройстваЗамена устройстваДиагностикаДиагностикаКонсультацияКонсультация

AirPods MaxAirPods ProEarPodsAirPodsWatch 6Watch 5Watch 4Watch 3Watch 2Watch 1Watch SE

Чистка наушниковГарантийное обслуживаниеАктивацияАктивацияАктивацияЧистка наушниковДиагностикаАктивацияСинхронизацияАктивацияДиагностикаСинхронизацияСинхронизацияЗамена устройстваЗамена устройства отЗамена устройства LСинхронизацияЗамена зарядного кейсаЗамена устройства целикомАктивацияСинхронизацияОбновление OSОбновление OSГарантийное обслуживаниеОбновление OSЗамена устройства RЗамена устройства RОбновление OSЗамена устройстваСинхронизацияОбновление OSОбновление OSСинхронизацияЗамена устройстваЗамена устройстваЗамена устройства LЗамена зарядного кейсаДиагностикаЗамена одного амбушюрЗамена устройстваЗамена устройства отЗамена устройстваАктивацияДиагностикаДиагностикаГарантийное обслуживаниеГарантийное обслуживаниеОбновление OSКоммерческая замена CaseДиагностикаДиагностика

Программа VMware Cloud Provider | RU

Требования Доступ к порталу Partner CentralУровень Professional

Уровень Enterprise

Уровень Premier

Требования Внесение в средство поиска партнеровУровень Professional

Уровень Enterprise

Уровень Premier

Требования Фирменная символика партнерской программыУровень Professional

Уровень Enterprise

Уровень Premier

Требования Значок VMware IaaS PoweredУровень Professional

Уровень Enterprise

Уровень Premier

Требования Предоставление материалов для пресс-релизовУровень Professional

Уровень Enterprise

Уровень Premier

Требования Лицензии не для перепродажиУровень Professional

Уровень Enterprise

Уровень Premier

Требования Демонстрационная среда для тестирования облакаУровень Professional

Уровень Enterprise

Уровень Premier

Требования Лицензии для внутреннего использованияУровень Professional

Уровень Enterprise

Уровень Premier

Требования Использование размещенных ИТ-услуг самим поставщиком услугУровень Professional

Уровень Enterprise

Уровень Premier

Требования Внесение в список на сайте vcloudproviders. vmware.com

vmware.comУровень Professional

Уровень Enterprise

Уровень Premier

Требования Возможность стать партнером Cloud Credits RedemptionУровень Professional

Уровень Enterprise

Уровень Premier

Требования Фонды развитияУровень Professional

Уровень Enterprise

Уровень Premier

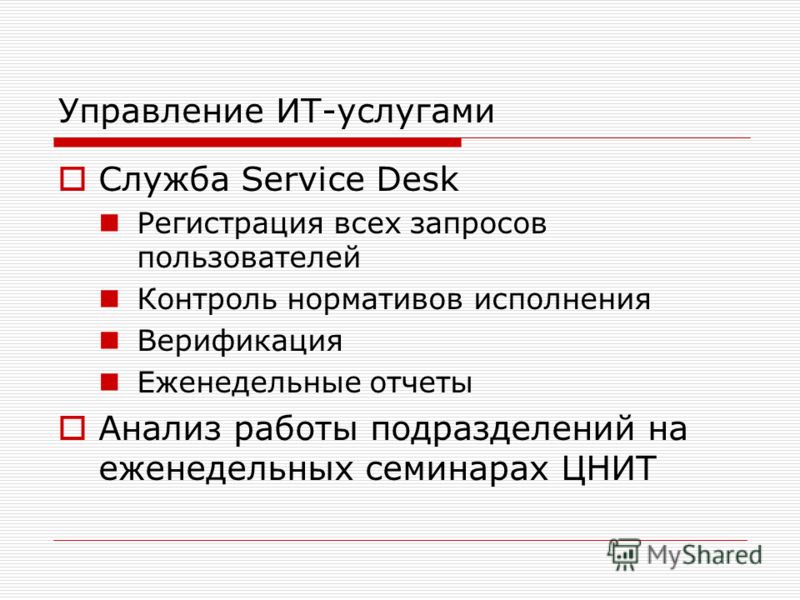

IntraService — Универсальная Service Desk система

IntraService используется для учета заявок в IT-отделе и как bug tracker для собственных разработок.

Внедрение ПО IntraService в группе компаний IEK преследовало цель-дать сотрудникам организации удобный инструмент для взаимодействия с ИТ, реализовать сервисную модель ИТ-услуг, повысить качество работы ИТ- департамента в части клиент-ориентированности, сроков реализации ИТ-задач, автоматизировать и интегрировать ИТ-процессы с другими сервисами компании.

В процессе внедрения было протестировано и получен опыт работы с несколькими системами, в том числе с ПО собственной разработки. Выбор в пользу Интрасервиса был сделан по следующим критериям.

Интуитивный интерфейс не требующий лишних действий, продуманная архитектура системы, обеспечивающая гибкую настройку без программирования, скорость работы системы и возможности по интеграции, невысокая стоимость ПО и его сопровождения. Не смотря на первичную простоту программы, отсутствие некоторых функций в сравнении с другим ПО и недостаточную «академичность», мы сознательно остановили свой выбор на IntraService.

При реализации проекта была создана иерархическая структура ИТ-сервисов, определены типы заявок по стандартам ITIL, роли пользователей на сервисах, определены группы исполнителей для разных территорий, скорректированы шаблоны уведомлений, настроены бизнес-процессы.

В процессе эксплуатации наращивался список используемого функционала системы с регулярным информированием и вовлечением всего персонала организации, корректировались бизнес-процессы. Проводилось нормирование ИТ-услуг по сервисам и типам заявок (время реакции, исполнения). Для повышения исполнительской дисциплины были внедрены предупреждающие сервисные уведомления, регламентные отчеты по расписанию о состоянии работ. Также были настроены регламентные процедуры по автоматическому закрытию и отмене заявок.

Проводилось нормирование ИТ-услуг по сервисам и типам заявок (время реакции, исполнения). Для повышения исполнительской дисциплины были внедрены предупреждающие сервисные уведомления, регламентные отчеты по расписанию о состоянии работ. Также были настроены регламентные процедуры по автоматическому закрытию и отмене заявок.

В настоящее время система интегрирована с AD организации, ряд сервисов используется для совместных работ по заявкам с сервисными ИТ-компаниями (обеспечено информирование и обратная связь). В структуре базы знаний размещена необходимая информация (ИТ-контакты, инструкции, документация к ПО организации). В каталоге активов размещена оргтехника, мобильные устройства и другое оборудование организации.

Кроме Web-интерфейса, система настроена на импорт заявок из нескольких почтовых ящиков с их автоматической обработкой, распределением по сервисам и назначением исполнителей, в том числе для внешних партнеров компании.

По просьбе других подразделений, в IntraService была настроена работа обеспечивающих сервисов по транспорту, хозяйственному и инженерному обеспечению компании. По запросам были созданы формы заявок, бланки для печати, настроены процессы их обработки. Все это без программирования и достаточно оперативно.

По запросам были созданы формы заявок, бланки для печати, настроены процессы их обработки. Все это без программирования и достаточно оперативно.

В планах стоит более активное использование мобильного клиента IntraService и СМС-информирования для ряда сервисов. Поэтапно происходит развитие интеграции программы с другим ПО, использование данных в аналитической отчетности.

Отзыв клиента (PDF, 590kb)>

systemd.service

Type = Настраивает тип запуска процесса для этой сервисной единицы. Один из простых , exec , разветвление , oneshot , dbus , notify или idle :

Если установлено значение

simple(значение по умолчанию, еслиExecStart =). указано, но не указаны ниType =, ниBusName =), диспетчер службы будет считать, что модуль запущен сразу после разветвления основного процесса обслуживания. это

ожидается, что процесс, настроенный с

это

ожидается, что процесс, настроенный с ExecStart =, является основным процессом служба. В этом режиме, если процесс предлагает функции другим процессам в системе, его каналы связи должны быть установлены до запуска службы (например, розетки, установленные systemd, через активацию сокета), так как менеджер службы немедленно приступит к запуску последующих модулей, сразу после создания основного процесса службы и перед выполнением двоичного файла службы.Обратите внимание, что это означает systemctl start командные строки дляпростых служббудут сообщать успех, даже если двоичный файл службы не может быть успешно запущен (например, потому что выбранныйПользователь =не существует или двоичный файл службы отсутствует).Тип

execаналогиченsimple, но служба manager будет считать, что модуль запущен сразу после выполнения основного служебного двоичного файла. Сервис

менеджер отложит запуск последующих единиц до этого момента. (Или другими словами:

Сервис

менеджер отложит запуск последующих единиц до этого момента. (Или другими словами: simpleпереходит к дальнейшим заданиям сразу после возвратаfork (), в то время какexecне будет продолжаться до того, какfork ()иexecve ()в процессе службы успешно.) Обратите внимание, что это означает systemctl запустить командные строки для службexecсообщит об ошибке, когда служба двоичный файл не может быть запущен успешно (например, потому что выбранный пользователь=не существует или двоичный файл службы отсутствует).Если установлено значение

, разветвление, ожидается, что процесс, настроенный сExecStart =вызоветfork ()как часть своего запуска. Родитель Ожидается, что процесс завершится после завершения запуска и настройки всех каналов связи. Ребенок

продолжает работать как основной сервисный процесс, и сервис-менеджер будет считать, что модуль запущен, когда

родительский процесс завершается. Это поведение традиционных служб UNIX.Если этот параметр используется, он

рекомендуется также использовать параметр

Ребенок

продолжает работать как основной сервисный процесс, и сервис-менеджер будет считать, что модуль запущен, когда

родительский процесс завершается. Это поведение традиционных служб UNIX.Если этот параметр используется, он

рекомендуется также использовать параметр PIDFile =, чтобы systemd могла надежно идентифицировать основной процесс обслуживания. systemd приступит к запуску последующих единиц, как только родительский процесс завершается.Поведение

oneshotаналогичноsimple; тем не менее, менеджер службы рассмотрит установку устройства после выхода из основного процесса. Тогда это будет начать последующие подразделения.RemainAfterExit =особенно полезно для этого типа службы.Type =oneshot— подразумеваемое значение по умолчанию, если ни один из нихType =илиExecStart =не указаны. Обратите внимание, что если это

опция используется без

Обратите внимание, что если это

опция используется без RemainAfterExit =служба никогда не войдет Состояние блока «активен», но происходит прямой переход от «активация» на «деактивация» или «мертвый», поскольку не настроен процесс, который должен работать непрерывно.В частности, это означает, что после запуска службы этого типа (и которая имеетRemainAfterExit =not set) он не будет отображаться как запущенный впоследствии, но как мертвый.Поведение

dbusаналогичнопростому; Однако, ожидается, что служба получит имя на шине D-Bus, как настроеноBusName =. systemd продолжит запуск дополнительных модулей после D-Bus название автобуса было получено.Сервисные единицы с этой настройкой неявно получают зависимости от модуляdbus.. Этот тип используется по умолчанию, если socket

socket BusName =указано. Сервисная единица этого типа считается находящейся в состояние активации до тех пор, пока не будет получено указанное имя шины. Считается активированным, пока занято название автобуса. После того, как название шины выпущено, услуга считается не обслуживаемой. функционал, который приводит к тому, что диспетчер служб пытается прекратить все оставшиеся процессы, принадлежащие службе.Сервисы, в которых имя шины сбрасывается при завершении работы Таким образом, логика должна быть готова к приемуSIGTERM(или любого другого сигнала настроен вKillSignal =) в качестве результата.Поведение

notifyаналогичноexec; однако это ожидается, что служба отправит уведомление через sd_notify (3) или эквивалентный вызов по завершении запуска. systemd продолжит запуск дополнительных модулей после того, как

это уведомление отправлено.Если используется эта опция,

systemd продолжит запуск дополнительных модулей после того, как

это уведомление отправлено.Если используется эта опция, NotifyAccess =(см. ниже) должен быть установлен для открытия доступа к сокету уведомлений, предоставленному systemd. ЕслиNotifyAccess =отсутствует или установлено значениеnone, будет принудительно установлено значениеосновной.Поведение

idleочень похоже наsimple; Однако, фактическое выполнение служебной программы откладывается до тех пор, пока не будут отправлены все активные задания.Это может быть использовано чтобы избежать чередования вывода служб оболочки с выводом состояния на консоль. Обратите внимание, что это тип полезен только для улучшения вывода на консоль, он бесполезен в качестве общего инструмента для упорядочивания единиц, а эффект этого типа службы подвержен 5-секундному таймауту, по истечении которого вызывается служебная программа. в любом случае.

в любом случае.

Обычно рекомендуется использовать Type = simple для длительного использования.

по возможности, так как это самый простой и быстрый вариант.Однако, поскольку этот тип услуги не

распространять сбои при запуске службы и не позволяет заказывать другие блоки до завершения

инициализация службы (что, например, полезно, если клиентам необходимо подключиться к службе через

некоторая форма IPC, и канал IPC устанавливается только самой службой — в отличие от этого

заблаговременно через активацию сокета или шины или аналогичным образом), во многих случаях этого может быть недостаточно. Если так, notify или dbus (последнее только в том случае, если сервис предоставляет D-Bus

интерфейс) являются предпочтительными вариантами, поскольку они позволяют программному коду службы точно планировать, когда

считать, что служба запущена успешно, и когда приступить к работе с дополнительными модулями. В

В notify Тип службы требует явной поддержки в кодовой базе службы (как sd_notify () или эквивалентный API должен быть вызван службой в соответствующем

time) — если он не поддерживается, то альтернативой является форк : он поддерживает традиционный

Протокол запуска службы UNIX. Наконец, exec может быть вариантом для случаев, когда это

достаточно, чтобы гарантировать, что двоичный файл службы запущен, и где двоичный файл службы сам не выполняет или мало

инициализация сама по себе (и ее инициализация вряд ли завершится неудачно).Обратите внимание, что использование любого типа, кроме простой , возможно, задерживает процесс загрузки, так как диспетчер служб должен ждать обслуживания

инициализация завершена. Поэтому рекомендуется не использовать без необходимости какие-либо типы, кроме простой . (Также обратите внимание, что обычно не рекомендуется использовать в режиме ожидания или oneshot для длительно работающих служб. )

)

RemainAfterExit = Принимает логическое значение, определяющее,

услуга считается активной, даже если все ее

процессы завершены.По умолчанию № .

GuessMainPID = Принимает логическое значение, определяющее,

systemd должна попытаться угадать основной PID службы, если она

не может быть определен надежно. Эта опция игнорируется, если только Тип = разветвление установлено и PIDFile = не задано, потому что для других типов

или с явно настроенным файлом PID основным PID является

всегда известно. Алгоритм угадывания может оказаться неверным

выводы, если демон состоит из более чем одного процесса.Если

основной PID не может быть определен, обнаружение неисправности и

автоматический перезапуск службы не будет работать надежно.

По умолчанию да .

PIDFile = Принимает путь, ссылающийся на файл PID службы. Использование этой опции рекомендуется для

Services, где

Использование этой опции рекомендуется для

Services, где Type = установлен на , разветвление . Указанный путь обычно указывает

в файл ниже / run / . Если указан относительный путь, он, следовательно, имеет префикс / run / .Менеджер службы считывает PID основного процесса службы из этого

файл после запуска сервиса. Диспетчер служб не будет записывать в настроенный здесь файл, хотя он

удалит файл после завершения работы службы, если он все еще существует. Файл PID не обязательно должен принадлежать

от привилегированного пользователя, но если он принадлежит непривилегированному пользователю, применяются дополнительные ограничения безопасности:

файл не может быть символической ссылкой на файл, принадлежащий другому пользователю (ни прямо, ни косвенно), и

PID-файл должен относиться к процессу, уже принадлежащему службе.

Обратите внимание, что в современных проектах следует избегать файлов PID. Используйте

Используйте Type = notify или Тип = простой , где это возможно, что не требует использования файлов PID для определения

основной процесс службы и позволяет избежать ненужного разветвления.

BusName = Принимает имя назначения D-Bus, которое эта служба должна использовать. Эта опция обязательна

для служб, где Type = установлен на dbus . Рекомендуется

всегда устанавливайте это свойство, если оно известно, чтобы упростить сопоставление имени службы с адресатом D-Bus.В частности, глаголы systemctl service-log-level / service-log-target используют

это.

ExecStart = Команды с их аргументами, которые

выполняется при запуске этой службы. Значение разбито на

ноль или более командных строк в соответствии с описанными правилами

ниже (см. раздел «Командные строки» ниже).

Если Type = не равно oneshot , должна быть дана ровно одна команда.Когда Type = oneshot используется, можно указать ноль или более команд. Команды могут быть указаны

предоставление нескольких командных строк в одной и той же директиве, или, альтернативно, эта директива может быть указана более

более одного раза с тем же эффектом. Если этому параметру присвоена пустая строка, список команд для запуска

сброшен, предыдущие назначения этой опции не будут иметь никакого эффекта. Если нет ExecStart = , то

указано, то служба должна иметь RemainAfterExit = yes и хотя бы один ExecStop = набора строк.(В службах отсутствуют как ExecStart = , так и ExecStop = недопустимы.)

Для каждой из указанных команд первым аргументом должен быть либо абсолютный путь к исполняемому файлу.

или простое имя файла без косых черт. При желании перед этим именем файла может быть поставлен ряд специальных

символов:

При желании перед этим именем файла может быть поставлен ряд специальных

символов:

Таблица 1. Специальные префиксы исполняемых файлов

| Префикс | Эффект |

|---|---|

« @ » | Если путь к исполняемому файлу 94 «9000» равен 9000 , второй указанный токен будет передан как « argv [0] » выполняемому процессу (вместо фактического имени файла), за которым следуют дополнительные указанные аргументы. |

«–» | Если путь к исполняемому файлу имеет префикс «–», записывается код выхода команды, обычно считающейся ошибкой (т.е. ненулевое состояние выхода или аварийный выход из-за сигнала). , но не имеет дальнейшего эффекта и считается приравненным к успеху. |

«: » | Если путь к исполняемому файлу имеет префикс «: », подстановка переменных среды (как описано в разделе «Командные строки» ниже) не применяется. |

« + » | Если путь к исполняемому файлу имеет префикс « + », то процесс выполняется с полными привилегиями. В этом режиме ограничения привилегий, настроенные с помощью User = , Group = , CapabilityBoundingSet = или различных параметров пространства имен файловой системы (например, PrivateDevices = , PrivateTmp = ), не применяются к вызываемой командной строке ( но по-прежнему влияет на любые другие строки ExecStart = , ExecStop = ,…). |

«! » | Подобно описанному выше символу « + », он позволяет вызывать командные строки с повышенными привилегиями. Однако, в отличие от « + », символ «! » изменяет исключительно эффект User = , Group = и SupplementaryGroups = , то есть только строфы, которые влияют на учетные данные пользователя и группы. Обратите внимание, что этот параметр может быть объединен с Обратите внимание, что этот параметр может быть объединен с DynamicUser = , и в этом случае пара динамических пользователей / групп выделяется до вызова команды, но изменение учетных данных остается на усмотрение самого выполняемого процесса. |

« !! » | Этот префикс очень похож на «! », однако он влияет только на системы, в которых отсутствует поддержка возможностей внешних процессов, то есть без поддержки AmbientCapabilities = . Он предназначен для использования с юнит-файлами, которые используют внешние возможности для запуска процессов с минимальными привилегиями везде, где это возможно, при этом оставаясь совместимыми с системами, которые не поддерживают внешние возможности. Обратите внимание, что когда используется « !! » и обнаружена система, в которой отсутствует поддержка внешних возможностей, любые настроенные разделы SystemCallFilter = и CapabilityBoundingSet = неявно изменяются, чтобы позволить порожденным процессам отбрасывать учетные данные и возможности самостоятельно, даже если это не разрешено. Более того, если используется этот префикс и обнаружена система, в которой отсутствует поддержка внешних возможностей, Более того, если используется этот префикс и обнаружена система, в которой отсутствует поддержка внешних возможностей, AmbientCapabilities = будет пропущено и не будет применяться. В системах, поддерживающих внешние возможности, « !! » не действует и является избыточным. |

« @ », «–», «: » и один из

« + » / «! » / « !! » можно использовать вместе, и они могут появляться в любом

порядок. Однако только один из « + », «! », « !! » может использоваться в

время.Обратите внимание, что эти префиксы также поддерживаются для других настроек командной строки,

т.е. ExecStartPre = , ExecStartPost = , ExecReload = , ExecStop = и ExecStopPost = .

Если указано более одной команды, команды

вызываются последовательно в том порядке, в котором они появляются в модуле

файл. Если одна из команд не работает (и не имеет префикса

«

Если одна из команд не работает (и не имеет префикса

« - »), остальные строки не выполняются, а

агрегат считается отказавшим.

Если Тип = разветвление не установлено,

процесс, запущенный через эту командную строку, будет считаться

основной процесс демона.

ExecStartPre = , ExecStartPost = Дополнительные команды, которые выполняются перед

или после команды в ExecStart = ,

соответственно. Синтаксис такой же, как у ExecStart = , за исключением того, что множественная команда

разрешены строки, и команды выполняются после

прочее, серийно.

Если любая из этих команд (без префикса

« - ») не выполняются, остальные не выполняются и

агрегат считается отказавшим.

ExecStart = команды запускаются только после

все ExecStartPre = команды без префикса

с успешным выходом « - «.

ExecStartPost = команды запускаются только после команд, указанных в ExecStart = были запущены успешно, как определено в Type = (я.е. процесс запущен для Type = simple или Type = idle , последний ExecStart = процесс завершился успешно для Type = oneshot , начальный

процесс успешно завершен для Введите = разветвление , « READY = 1 » отправлено для Type = notify , или BusName = было взято для Тип = dbus ).

Обратите внимание, что ExecStartPre = не может быть

используется для запуска длительных процессов.Все процессы разветвлены

выключено процессами, вызванными через ExecStartPre = , будет

быть убитым до того, как будет запущен следующий служебный процесс.

Обратите внимание, что если любая из команд, указанных в ExecStartPre = , ExecStart = или ExecStartPost = сбой (и не имеют префикса

« - », см. Выше) или тайм-аут до того, как служба будет полностью запущена, выполнение продолжается с командами

указано в ExecStopPost = , команды в ExecStop = пропускаются.

Обратите внимание, что выполнение ExecStartPost = учитывается с целью До = / После = ограничений заказа.

ExecCondition = Необязательные команды, которые выполняются перед командой (ами) в ExecStartPre = .

Синтаксис такой же, как для ExecStart = , за исключением того, что разрешены несколько командных строк и

команды выполняются одна за другой поочередно.

Поведение похоже на ExecStartPre = и гибридную проверку состояния: когда ExecCondition = команда завершается с кодом выхода от 1 до 254 (включительно), остальные

команды пропускаются, а блок — , а не , помеченный как сбойный. Однако если ExecCondition = команда завершается с 255 или ненормально (например, тайм-аут, прерванный

сигнал и т. д.), модуль будет считаться неисправным (а остальные команды будут пропущены).Код выхода 0 или

те, которые соответствуют SuccessExitStatus = , продолжат выполнение до следующей команды (команд).

Те же рекомендации по отключению длительных процессов в ExecStartPre = также применяется к ExecCondition = . ExecCondition = также запустит команды

в ExecStopPost = , как часть остановки службы, в случае любого ненулевого или ненормального

выходы, подобные описанным выше.

ExecReload = Команды для запуска конфигурации

перезагрузить в сервисе. Этот аргумент принимает несколько команд

линий, следуя той же схеме, что и для ExecStart = выше. Использование этой настройки

по желанию. Подстановка спецификатора и переменной окружения

здесь поддерживается по той же схеме, что и для ExecStart = .

Устанавливается одна дополнительная специальная переменная среды: если

известно, $ MAINPID установлен для основного процесса

демона и может использоваться для командных строк, таких как

следующее:

ExecReload = kill -HUP $ MAINPID

Обратите внимание, однако, что перезагрузка демона путем отправки сигнала

(как и в приведенном выше примере) обычно не лучший выбор,

потому что это асинхронная операция и, следовательно, не

подходит для заказа перезагрузки нескольких сервисов для каждого

Другой.Настоятельно рекомендуется установить ExecReload = к команде, которая не только

запускает перезагрузку конфигурации демона, но также

синхронно ожидает его завершения. Например,

dbus-брокер (1)

использует следующее:

ExecReload = busctl call org.freedesktop.DBus \

/ org / freedesktop / DBus org.freedesktop.DBus \

ReloadConfig

ExecStop = Команды, выполняемые для остановки службы, запущенной через ExecStart = .Этот аргумент принимает несколько командных строк по той же схеме.

как описано выше для ExecStart = . Использование этого параметра не является обязательным. После

команды, настроенные в этой опции, выполняются, подразумевается, что служба остановлена, и любые

оставшиеся для него процессы завершаются в соответствии с настройкой KillMode = (см.

systemd.kill (5)).

Если эта опция не указана, процесс завершается отправкой сигнала, указанного в KillSignal = или RestartKillSignal = , когда остановка обслуживания

просил.Поддерживается подстановка указателей и переменных среды (в том числе $ MAINPID , см. Выше).

Обратите внимание, что обычно недостаточно указать команду для этого параметра, которая запрашивает только

сервис для завершения (например, отправив ему некоторую форму сигнала завершения), но не

подождите, пока это произойдет. Поскольку остальные процессы сервисов убиваются согласно KillMode = и KillSignal = или RestartKillSignal = , как описано выше, сразу после выхода из команды, это

может не привести к чистой остановке.Следовательно, указанная команда должна быть синхронной операцией, а не

асинхронный.

Обратите внимание, что команды, указанные в ExecStop = , выполняются только тогда, когда служба

начал успешно сначала. Они не вызываются, если служба вообще не запускалась или

не удалось запустить, например, из-за любой из команд, указанных в ExecStart = , ExecStartPre = или ExecStartPost = не удалось (и не имели префикса

«–», см. Выше) или истекло время ожидания.Используйте ExecStopPost = для вызова команд, когда

служба не запустилась правильно и снова закрывается. Также обратите внимание, что операция остановки всегда

выполняется, если служба запущена успешно, даже если процессы в службе завершились на их

владеют или были убиты. Команды останова должны быть готовы к тому, чтобы иметь дело с этим случаем. $ MAINPID будет сброшен, если systemd знает, что основной процесс завершился к моменту вызова команд остановки.

Запросы на перезапуск службы реализуются как операции остановки, за которыми следуют операции запуска. Этот

означает, что ExecStop = и ExecStopPost = выполняются во время

перезапуск службы.

Рекомендуется использовать этот параметр для команд, которые обмениваются данными с запрашивающей службой

чистое прекращение. Вместо этого для посмертной очистки используйте ExecStopPost = .

ExecStopPost = Дополнительные команды, которые выполняются после остановки службы.Сюда входят случаи, когда

использовались команды, настроенные в ExecStop = , где у службы нет ExecStop = определено, или служба неожиданно завершила работу. Этот аргумент принимает несколько

командные строки, следуя той же схеме, что и для ExecStart = . Использование этих настроек

не является обязательным. Поддерживается подстановка указателей и переменных среды. Обратите внимание, что — в отличие от ExecStop = — команды, указанные в этом параметре, вызываются, когда служба не запускается

правильно и снова выключен.

Рекомендуется использовать эту настройку для операций очистки, которые должны выполняться, даже если служба не запустилась правильно. Команды, настроенные с этим параметром, должны работать, даже если служба не запустилась на полпути и оставила не полностью инициализированные данные. Как сервис процессы были завершены уже при выполнении команд, указанных в этом параметре, они должны не пытайтесь общаться с ними.

Обратите внимание, что все команды, настроенные с помощью этого параметра, вызываются с кодом результата

service, а также код выхода и статус основного процесса, заданные в $ SERVICE_RESULT , $ EXIT_CODE и $ EXIT_STATUS переменных среды, см.

systemd.exec (5) для

подробности.

Обратите внимание, что выполнение ExecStopPost = учитывается с целью До = / После = ограничений заказа.

RestartSec = Настраивает время перехода в спящий режим перед перезапуском

сервис (как настроено с Restart = ).

Принимает безразмерное значение в секундах или значение временного интервала, например

как «5 минут 20 секунд». По умолчанию 100 мс.

TimeoutStartSec = Настраивает время ожидания запуска. Если служба демона не сигнализирует о запуске

завершение в течение настроенного времени, служба будет считаться неудачной и будет снова закрыта.В

точное действие зависит от параметра TimeoutStartFailureMode = . Принимает безразмерное значение в

секунд или значение промежутка времени, например «5мин 20с». Передайте « infinity », чтобы отключить логику тайм-аута.

По умолчанию DefaultTimeoutStartSec = из файла конфигурации менеджера, кроме случаев, когда Type = oneshot Используется , в этом случае тайм-аут отключен по умолчанию (см.

systemd-system.conf (5)).

Если служба Type = notify отправляет « EXTEND_TIMEOUT_USEC =… », это может вызвать

время начала должно быть увеличено за пределы TimeoutStartSec = .Первое получение этого сообщения

должно произойти до того, как будет превышено TimeoutStartSec = , и как только время начала превысит TimeoutStartSec = , диспетчер службы разрешит запуск службы при условии

услуга повторяет « EXTEND_TIMEOUT_USEC =… » в течение указанного интервала до тех пор, пока услуга

статус запуска заканчивается « READY = 1 «. (видеть

sd_notify (3)).

TimeoutStopSec = Этот параметр служит двум целям.Во-первых, он настраивает время ожидания каждого ExecStop = команда. Если время ожидания любого из них истекает, последующие ExecStop = команды

пропускаются, и обслуживание будет прекращено SIGTERM . Если нет ExecStop = указаны команды, служба немедленно получает SIGTERM . Это поведение по умолчанию

можно изменить с помощью параметра TimeoutStopFailureMode = . Во-вторых, он настраивает время

дождаться остановки самой службы.Если он не завершится в указанное время, он будет прекращен принудительно

на SIGKILL (см. KillMode = в

systemd.kill (5)).

Принимает безразмерное значение в секундах или значение временного интервала, например

как «5 минут 20 секунд». Передайте « infinity », чтобы отключить

логика тайм-аута. По умолчанию DefaultTimeoutStopSec = от менеджера

файл конфигурации (см.

systemd-system.conf (5)).

Если служба Type = notify отправляет « EXTEND_TIMEOUT_USEC =… », это может вызвать

время остановки должно быть увеличено за пределы TimeoutStopSec = .Первое получение этого сообщения

должно произойти до того, как будет превышено TimeoutStopSec = , и как только время остановки превысит TimeoutStopSec = , диспетчер службы разрешит службе продолжить остановку при условии

служба повторяет « EXTEND_TIMEOUT_USEC =… » в течение указанного интервала или завершает работу

(см. sd_notify (3)).

TimeoutAbortSec = Этот параметр настраивает время ожидания завершения службы, если она была прервана из-за

Тайм-аут сторожевого таймера (см. WatchdogSec = ).Если у сервиса короткий TimeoutStopSec = эту опцию можно использовать, чтобы дать системе больше времени для записи дампа ядра службы. По истечении срока действия услуги

будет принудительно завершено SIGKILL (см. KillMode = в

systemd.kill (5)). Основной файл будет

быть усеченным в этом случае. Используйте TimeoutAbortSec = , чтобы установить разумный тайм-аут для дампа ядра на

сервис, который достаточно велик, чтобы записать все ожидаемые данные, и в то же время достаточно короткий, чтобы справиться с ошибкой службы

в свое время.

Принимает безразмерное значение в секундах или значение временного интервала, например «5 мин 20 с». Передайте пустое значение, чтобы пропустить

выделенный сторожевой таймер прерывает обработку тайм-аута и откатывается TimeoutStopSec = . Проходить

« infinity », чтобы отключить логику тайм-аута. По умолчанию DefaultTimeoutAbortSec = от

файл конфигурации менеджера (см.

systemd-system.conf (5)).

Если служба Type = notify обрабатывает SIGABRT непосредственно (вместо того, чтобы полагаться на

на ядре для записи дампа ядра) он может отправить « EXTEND_TIMEOUT_USEC =… » на

увеличил время прерывания до TimeoutAbortSec = .Первое получение этого сообщения

должно произойти до того, как будет превышено TimeoutAbortSec = , и как только время прерывания превысит TimeoutAbortSec = , диспетчер службы разрешит прекращение службы при условии

служба повторяет « EXTEND_TIMEOUT_USEC =… » в течение указанного интервала или завершает работу

(см. sd_notify (3)).

TimeoutSec = Сокращение для настройки обоих TimeoutStartSec = и TimeoutStopSec = до указанного значения.

TimeoutStartFailureMode = , TimeoutStopFailureMode = Эти параметры настраивают действие, выполняемое в случае, если служба демона не подает сигнал

запуск в течение его настроенного TimeoutStartSec = , соответственно, если он не останавливается в течение TimeoutStopSec = . Принимает один из , завершить , прервать и убить . Обе опции по умолчанию , завершают .

Если terminate установлено, служба будет корректно завершена путем отправки сигнала

указано в KillSignal = (по умолчанию SIGTERM , см.

systemd.kill (5)). Если

служба не завершает FinalKillSignal = отправляется после TimeoutStopSec = . Если установлено abort , отправляется WatchdogSignal = вместо этого применяется TimeoutAbortSec = перед отправкой FinalKillSignal = .Этот параметр можно использовать для анализа служб, которые периодически не запускаются или не завершаются.

При использовании kill служба немедленно завершается отправкой FinalKillSignal = без дополнительного тайм-аута. Этот параметр можно использовать для ускорения

отключение отказавших служб.

RuntimeMaxSec = Задает максимальное время запуска службы. Если это используется и услуга была

активен дольше указанного времени, он прекращается и переводится в состояние отказа.Обратите внимание, что этот параметр

не влияет на службы Type = oneshot , так как они прекращаются сразу после

активация завершена. Передайте « infinity » (по умолчанию), чтобы настроить отсутствие времени выполнения.

предел.

Если служба Type = notify отправляет « EXTEND_TIMEOUT_USEC =… », это может вызвать

время выполнения должно быть расширено за пределы RuntimeMaxSec = . Первое получение этого сообщения

должно произойти до того, как будет превышено RuntimeMaxSec = , и как только время выполнения расширится RuntimeMaxSec = , диспетчер службы разрешит службе продолжить работу при условии

услуга повторяет « EXTEND_TIMEOUT_USEC =… » в течение указанного интервала до тех пор, пока услуга

отключение достигается « STOPPING = 1 » (или завершением).(видеть

sd_notify (3)).

WatchdogSec = Настраивает тайм-аут сторожевого таймера для службы.

Сторожевой таймер активируется после завершения запуска. В

сервис должен позвонить

sd_notify (3)

регулярно с « WATCHDOG = 1 » (т. е.

«keep-alive ping»). Если время между двумя такими звонками равно

больше настроенного времени, то услуга помещается в

состояние сбоя, и оно будет прекращено с SIGABRT (или сигнал, указанный WatchdogSignal = ).Установив Перезапуск = от до при отказе , на сторожевом таймере , на ненормальном или всегда , услуга будет автоматически

перезапущен. Настроенное здесь время будет передано

выполненный сервисный процесс в WATCHDOG_USEC = переменная среды. Этот

позволяет демонам автоматически включать проверку активности проверки связи

логика, если для службы включена поддержка сторожевого таймера.Если это

используется опция, NotifyAccess = (см. ниже)

должен быть установлен для открытия доступа к сокету уведомлений

предоставляется systemd. Если NotifyAccess = — это

не задано, будет неявно установлено значение main .

По умолчанию 0, что отключает эту функцию. Сервис может

проверьте, ожидает ли диспетчер службы поддержки активности сторожевого пса

уведомления. Видеть

sd_watchdog_enabled (3)

для подробностей.

sd_event_set_watchdog (3)

может использоваться для включения поддержки автоматического сторожевого таймера.

Restart = Определяет, должна ли служба

перезапускается, когда сервисный процесс завершается, завершается или

время ожидания истекло. Процесс обслуживания может быть основным

сервисный процесс, но он также может быть одним из процессов

указано с ExecStartPre = , ExecStartPost = , ExecStop = , ExecStopPost = , или ExecReload = .Когда смерть процесса

является результатом работы systemd (например, остановка службы или

перезапуск), служба не будет перезапущена. Таймауты включают

отсутствует крайний срок «keep-alive ping» и служба

таймауты запуска, перезагрузки и остановки операции.

Принимает одну из № , в успешном , на отказ , на ненормальном , сторожевой , при прерывании , или всегда .Если установлено значение нет (по умолчанию), служба будет

не перезапускаться. Если установлено значение при успешном завершении ,

будет перезапущен только тогда, когда процесс обслуживания завершится правильно.

В этом контексте чистый выход означает любое из следующего:

- код выхода 0;

- для типов, отличных от

Тип = oneshot, один из сигналовSIGHUP,SIGINT,SIGTERM, илиSIGPIPE; - статусы выхода и сигналы, указанные в

SuccessExitStatus =.

Если установлено на при отказе , сервис будет перезапущен

когда процесс завершается с ненулевым кодом выхода,

завершается сигналом (в том числе на дампе ядра, но исключая

вышеупомянутые четыре сигнала), когда операция (например,

перезагрузка службы) истекает, и когда настроенный сторожевой таймер

срабатывает тайм-аут. Если установлено значение на ненормальном ,

служба будет перезапущена после завершения процесса

по сигналу (в том числе на дампе ядра, исключая

вышеупомянутые четыре сигнала), когда время ожидания операции истекло, или

при срабатывании тайм-аута сторожевого таймера.Если установлено на on-abort , услуга будет только перезапущена

если процесс обслуживания завершается из-за неперехваченного сигнала, не

указан как чистый статус выхода. Если установлено на on-watchdog , сервис будет перезапущен

только если истечет время ожидания сторожевого таймера для службы. Если установлено

на всегда , услуга будет перезапущена

независимо от того, вышел он чисто или нет, был прекращен

ненормально по сигналу или истекло время ожидания.

Таблица 2. Причины выхода и результат действия Restart = settings

| Параметры перезапуска / причины выхода | нет | всегда | при отказе | при отказе | при отказе | при сбое | |

|---|---|---|---|---|---|---|---|

| Код или сигнал чистого выхода | X | ||||||

| Код нечистого выхода | X | X | |||||

| X | X | Unclean сигнал | |||||

| Тайм-аут | X | 9028 9 | X | X | |||

| Watchdog | X | X | X | X |

| Правило | Протокол | Порт (а) | IPRange (s) | Описание IPRange |

|---|---|---|---|---|

| Проверка работоспособности | TCP | NodePort (s) ( .spec.healthCheckNodePort для .spec.externalTrafficPolicy = Локальный ) | Подсеть CIDR | kubernetes.io/rule/nlb/health= |

| Клиентский трафик | TCP | NodePort (ов) | .spec.loadBalancerSourceRanges (по умолчанию 0.0.0.0/0 ) | kubernetes.io/rule/nlb/client= |

| MTU Discovery | ICMP | 3,4 | .spec.loadBalancerSourceRanges (по умолчанию 0.0,0.0 / 0 ) | kubernetes.io/rule/nlb/mtu= |

Чтобы ограничить IP-адреса клиентов, которые могут получить доступ к Network Load Balancer,

укажите loadBalancerSourceRanges .

спецификации:

loadBalancerSourceRanges:

- «143.231.0.0/16»

Примечание: Если

.spec.loadBalancerSourceRangesне установлен, Kubernetes разрешает трафик от0.0.0.0/0к группам безопасности узлов.Если узлы имеют общедоступные IP-адреса, имейте в виду, что трафик, не связанный с NLB, также может достигать всех экземпляров в этих измененных группах безопасности.

Другие аннотации CLB для Tencent Kubernetes Engine (TKE)

Существуют и другие аннотации для управления балансировщиками облачной нагрузки на TKE, как показано ниже.

метаданные:

имя: my-service

аннотации:

# Привязать балансировщики нагрузки к указанным узлам

service.kubernetes.io/qcloud-loadbalancer-backends-label: введите (значение1, значение2)

# ID существующего балансировщика нагрузки

служба.kubernetes.io/tke-existed-lbid:lb-6swtxxxx

# Пользовательские параметры для балансировщика нагрузки (LB), пока не поддерживает изменение типа LB

service.kubernetes.io/service.extensiveParameters: ""

# Пользовательские параметры для прослушивателя LB

service.kubernetes.io/service.listenerParameters: ""

# Указывает тип балансировщика нагрузки;

# допустимые значения: классический (Classic Cloud Load Balancer) или application (Application Cloud Load Balancer)

service.kubernetes.io / loadbalance-type: xxxxx

# Определяет метод выставления счетов за пропускную способность общедоступной сети;

# допустимые значения: TRAFFIC_POSTPAID_BY_HOUR (счет за трафиком) и BANDWIDTH_POSTPAID_BY_HOUR (счет за пропускную способность).

service.kubernetes.io/qcloud-loadbalancer-internet-charge-type: xxxxxx

# Определяет значение полосы пропускания (диапазон значений: [1,2000] Мбит / с).

service.kubernetes.io/qcloud-loadbalancer-internet-max-bandwidth-out: «10»

# Когда эта аннотация установлена, балансировщики нагрузки будут регистрировать только узлы

# с запущенным подом, иначе все узлы будут зарегистрированы.service.kubernetes.io/local-svc-only-bind-node-with-pod: правда

Тип Внешнее имя

Службы типа ExternalName сопоставляют Службу с именем DNS, а не с типичным селектором, таким как my-service или cassandra . Вы указываете эти службы с параметром spec.externalName .

Это определение службы, например, отображает my-service Service в пространстве имен prod до my.database.example.com :

Версия: v1

вид: Сервис

метаданные:

имя: my-service

пространство имен: prod

спецификация:

тип: ExternalName

externalName: my.database.example.com

Примечание. ExternalName принимает строку адреса IPv4, но как DNS-имена, состоящие из цифр, а не как IP-адрес. Внешние имена, похожие на адреса IPv4, не разрешаются CoreDNS или ingress-nginx, поскольку ExternalName предназначен для указания канонического DNS-имени. Чтобы жестко закодировать IP-адрес, рассмотрите возможность использования безголовые службы.

При поиске узла my-service.prod.svc.cluster.local служба DNS кластера

возвращает запись CNAME со значением my.database.example.com . Доступ my-service работает так же, как и другие службы, но с важными

разница в том, что перенаправление происходит на уровне DNS, а не через проксирование или

пересылка. Если позже вы решите переместить свою базу данных в кластер, вы

может запускать свои поды, добавлять соответствующие селекторы или конечные точки и изменять

Служба типа .

Предупреждение:У вас могут возникнуть проблемы с использованием ExternalName для некоторых распространенных протоколов, включая HTTP и HTTPS. Если вы используете ExternalName, то имя хоста, используемое клиентами внутри вашего кластера, отличается от имени, на которое ссылается ExternalName.

Для протоколов, использующих имена хостов, это различие может привести к ошибкам или неожиданным ответам. HTTP-запросы будут иметь заголовок

Host:, который исходный сервер не распознает; Серверы TLS не смогут предоставить сертификат, соответствующий имени хоста, к которому подключился клиент.

внешних IP-адресов

Если есть внешние IP-адреса, которые маршрутизируют один или несколько узлов кластера, Kubernetes Services могут быть доступны на этих внешних IP-адреса . Трафик, входящий в кластер с внешним IP-адресом (в качестве IP-адреса назначения), на служебном порте,

будет направлен на одну из конечных точек службы. внешних IP-адресов не управляются Kubernetes и находятся под его ответственностью.

администратора кластера.

В спецификации службы externalIPs можно указать вместе с любым из ServiceTypes .В приведенном ниже примере к « my-service » могут получить доступ клиенты по « 80.11.12.10:80 » ( externalIP: порт )

Версия: v1

вид: Сервис

метаданные:

имя: my-service

спецификация:

селектор:

приложение: MyApp

порты:

- имя: http

протокол: TCP

порт: 80

targetPort: 9376

externalIPs:

- 80.11.12.10

Недостатки

Использование прокси пользовательского пространства для VIP-персон работает в малых и средних масштабах, но будет не масштабируются до очень больших кластеров с тысячами сервисов.В оригинальное дизайнерское предложение порталов есть более подробная информация об этом.

Использование прокси-сервера пользовательского пространства скрывает исходный IP-адрес пакета, услуга. Это делает невозможными некоторые виды сетевой фильтрации (брандмауэра). Iptables прокси-режим не работает неясные исходные IP-адреса в кластере, но это по-прежнему влияет на клиентов, проходящих через балансировщик нагрузки или узел-порт.

Поле Тип разработано как вложенная функциональность — каждый уровень добавляет

предыдущий. Это строго не требуется для всех облачных провайдеров (например, для облачных сервисов).г. Google Compute Engine делает

не нужно выделять NodePort , чтобы LoadBalancer работал, но AWS это делает)

но текущий API требует этого.

Реализация виртуального IP

Предыдущей информации должно быть достаточно для многих людей, которые хотят использовать Сервисы. Однако за кулисами происходит многое, что может быть стоит понять.

Как избежать столкновений

Одна из основных философий Kubernetes заключается в том, что вы не должны подвержен ситуациям, которые могут привести к провалу ваших действий не по вине из ваших собственных.Для дизайна ресурса Сервиса это означает, что вы выбираете свой собственный номер порта, если этот выбор может противоречить чужой выбор. Это отказ изоляции.

Чтобы вы могли выбрать номер порта для ваших Сервисов, мы должны убедитесь, что никакие две службы не могут конфликтовать. Kubernetes делает это, выделяя каждый Сервис имеет собственный IP-адрес.

Чтобы гарантировать, что каждая служба получает уникальный IP-адрес, внутренний распределитель атомарно обновляет глобальную карту распределения в etcd перед созданием каждой Услуги.Объект карты должен существовать в реестре для Услуги для присвоения IP-адресов, в противном случае творения будут ошибка с сообщением, указывающим, что IP-адрес не может быть выделен.

В плоскости управления за создание этого карта (необходима для поддержки перехода со старых версий Kubernetes, которые использовали блокировка в памяти). Kubernetes также использует контроллеры для проверки недействительности назначения (например, из-за вмешательства администратора) и для очистки выделенных IP-адреса, которые больше не используются никакими Сервисами.

Сервисные IP-адреса